Robots.txt 자세한설명, 설정 예제

Robots.txt 자세한설명, 설정 예제

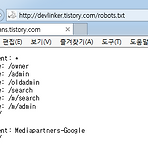

로봇 배제 표준[Robots exclusion standard] Rotobs.txt는 도메인을 가지고 있는 웹 사이트의 콘텐츠(contents)를 로봇이 접근하여 크롤링하는 것을 방지하기 위한 규약을 기술해 놓은 파일이다. 1994년 6월에 만들어 졌지만 이 규약은 권고안이기 때문에 접근 방지 설정을 하더라도 강제성이 없으며 실제 접근이 가능하다. 파일의 위치는 도메인의 root폴더에 위치한다. 예를들어, 나의 티스토리 도메인은 http://devlinker.tistory.com 이며, 브라우저에서 http://devlinker.tistory.com/robots.txt 입력하면 확인가능하다. 예제> 1. 사이트내에 모든 문서를 모든 로봇에게 접근 허용 User-agent: *

: tar 명령어는 파일이나 디렉토리를 하나의 파일로 묶는다. 파일을 백업하거나 전송할때 편하게 하나의 파일로 묶을 때 주로 쓰인다. *사용법: tar[옵션] 파일명1 파일명2 [옵션] 파일명1 : 일을 압축이나 묶음으로 만들어진 결과물로 나올 파일명을 지정한다. 파일명2 : 압축이나 묶음으로 만들 파일들을 지정한다. -x 아카이브로부터 파일을 푼다. -c 새로운 아카이브를 만듬 -v 처리되는 과정의 상세 정보를 보여줌 -z gzip으로 압축, ungzip으로 압축해제 -j bzip2를 이용해 압축 -t 아카이브 되는 목록을 보여줌 -d 아카이브와 파일 시스템간의 차이점을 비교 -f 옵션 다음 이름 지정으로, 기본값으로 설정된 이름을 변경 가능. -r 아카이브 끝에 새로운 파일을 추가적으로 생성 -u 아..

- Total

- Today

- Yesterday

- 프로젝트관리전문가

- IT-PMP

- 디지털서명

- 소프트웨어대회

- 타임스탬프

- 더불어 민주당

- 리눅스

- SW대회

- 자유한국당

- 코드스쿨

- 프로그래밍대회

- 안드로이드 화면 밝기 조절

- 온라인저지

- PyQt

- 관련사이트

- websocket

- stamp

- Python

- 서버주소

- qwebview

- 사용법

- setup.py

- 파이썬

- 파이썬프레임워크

- 명령어

- signtool

- Android

- ORACLE 프로시져생성

- WSS

- .svn

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |